이 누리집은

대한민국 공식 전자정부 누리집입니다.

이 누리집은

대한민국 공식 전자정부 누리집입니다.

점검 중

<모두의 말뭉치>

일부 기능 장애로 인하여 해당 신청이 불가능합니다.

최대한 빠르게 복구할 수 있도록 노력하겠습니다.

* 시스템 이용 장애 문의: 051-927-7111

과제 개요

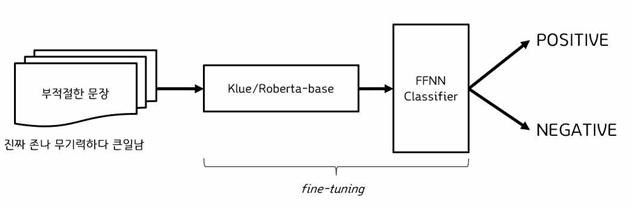

부적절성 문장에 대한 태도 탐지 과제는 부적절하게 표현된 문장 표현의 문맥상 긍정적 또는 부정적 태도를 판단하는 작업이다. 부적절 표현 맥락에서의 태도 판단은 향후 온라인 플랫폼의 콘텐츠를 감시하거나 댓글 필터링 등 다양한 분야에서 응용될 수 있다는 점에서 의의가 있다.

항목 | 내용 |

입력 문장 | "쥐엔장 ~ 믿고있었다구~" |

분류 | "POSITIVE" |

부적절성 문장에 대한 태도 탐지 과제는 문장 내의 부적절한 표현이 주어졌을 때, 해당 표현의 문맥상 긍정적 태도 또는 부정적 태도를 탐지하는 것을 목표로 한다. 즉 과제의 주요 목표는 문장의 전체적인 맥락을 고려하여 부적절한 표현에서 드러난 태도를 올바르게 판단하는 것이다.

학습용 데이터 세트는 부적절한 표현이 포함된 문장과 해당 문장의 '문맥(context)'으로 구성된다. 이 과제의 성능 기준은 제공된 부적절한 표현의 문맥상 긍정성 또는 부정성을 정확히 판단하는지를 본다.

이 과제는 평가 데이터의 각 입력 문장을 ‘부정적(NEGATIVE)’ 혹은 ‘긍정적(POSITIVE)’ 범주로 분류하는 것으로 정의된다. 평가 지표는 정답 데이터 세트와 예측 데이터 세트의 주석(annotation)을 문장 단위로 비교한 F1-점수이다.

분류 |

내용 |

예시 |

비고 |

입력 |

문장 |

"마간호사 존나멋있고 존나웃겨" "진짜 존나 무기력하다 큰일남" |

문자열 |

출력 |

분류 결과 |

"NEGATIVE": "문맥상 부정적 문장", "POSITIVE": "문맥상 긍정적 문장" |

문자열 |

평가 |

Micro F1-score, Macro F1-score |

|

|

데이터 세트 구축 과정에서 개인정보는 비식별화하였다. 이름, 출신/소속, 번호, 온라인 계정, 주소, 상호명, 상표명은 비윤리적 표현의 대상 여부와 관계없이 모두 비식별화되어 있으며 그 외 장소 이름, 창작물 이름 등은 비윤리적 표현의 대상일 경우만 비식별화되어 있다.

데이터 세트의 구성

구분 | 훈련 | 검증 | 평가 |

문장 수 | 12,990 | 1,624 | 1,624 |

평가 지표: F1 점수

기준 모델(베이스라인 모델): kleu/roberta-base 기반 학습 모델

- https://github.com/teddysum/Korean_IAU_2023

대회 참가 규정

- 인공지능의 한국어 능력 평가에 관심 있는 누구나 팀을 구성하여 참가할 수 있다.

- 팀 구성원은 국립국어원 언어정보나눔터 회원이어야 한다.

- 참가 팀은 과제를 해결한 결과를 정해진 양식에 맞추어 제출한다.

- 라이선스에 문제가 없는 모델을 개발하여야 한다.

- 외부 API를 통해 호출하는 모델(OpenAI API 등)은 제출할 수 없다.

- 모두의 말뭉치를 포함한 외부에 공개된 데이터는 사용이 가능하다(저작권 등 책임은 참가 팀에게 있음). 과제 데이터(말뭉치)를 초거대언어모델(LLM) 기반 자동 증강하여 사용할 수 있다.

시스템 사용 방법: 알립니다 → 사용 안내 참고

문의: 진행 중 과제 → 문의